Meta Avatars SDK for Unity (4)|ハンドトラッキングでアバターの腕・手・指を動かす

本記事では Meta Avatars SDK のアバターの腕・手・指をハンドトラッキングで動かせるようにする方法をまとめます.

検証環境・前提条件

- Unity 2020.3.25f1

- Meta Avatars SDK 9.0

- Oculus Integration 35.0

Meta Avatars SDK は現時点では Unity 2020 LTS が前提となっています.

検証用シーン作成

本記事はこちらの記事の続きとなっております.こちらが済んでいる前提とします.

ハンドトラッキング設定

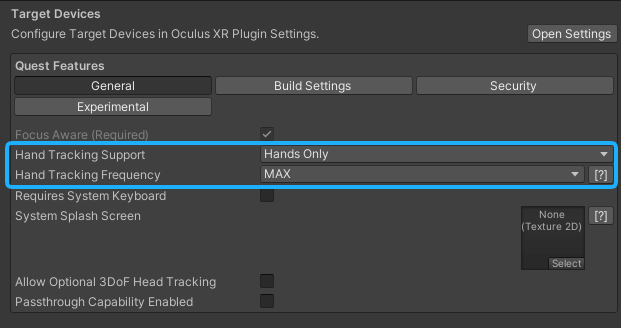

Assets/Oculus/OculusProjectConfig.asset を開き,ハンドトラッキングが出来るように設定を以下のようにします.

- Hand Tracking Support : Hands Only

- Hand Tracking Frequency : MAX

動作用のサンプルコード

ハンドトラッキング用の OvrAvatarInputManager 具象クラスを実装します.以下,サンプルコードです.

Body Tracking コンポーネントの置き換え

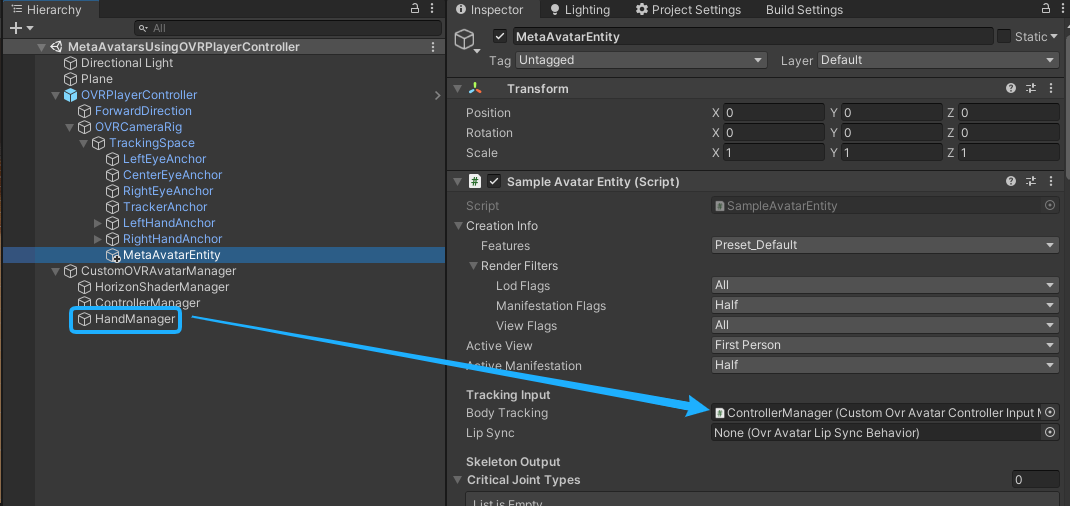

上のサンプルコードで実装したコンポーネントを適当な空オブジェクトにアタッチします. 下図の場合,空オブジェクトを「HandManager」という名前にしました.

SampleAvatarEntity の TrackingInput/BodyTracking の所に,このコンポーネントを当てはめます.

動作確認

Air Link で動作確認しています. 自分の手・指・腕の動きに合わせて Meta Avatars SDK のアバターの動きも連動できるようになりました.